आपके कंप्यूटर पर संपूर्ण वेबसाइट या सिर्फ कुछ वेब पेज सहेजना उन लोगों के लिए उपयोगी हो सकता है, जिनके पास समय के साथ एक सीमित कनेक्शन है या जो ट्रेन या प्लेन द्वारा ट्रांसफर के दौरान लैपटॉप पर पढ़ने के लिए कुछ तैयार करना चाहते हैं।

मुझे नहीं लगता कि यह अक्सर होगा, अन्य बातों के अलावा इस लेख की उपयोगिता फीड की उपस्थिति से सीमित हो सकती है जो कि फीडडोमन या माइक्रोसॉफ्ट आउटलुक जैसे प्रोग्राम का उपयोग करके पीसी पर सेव की जा सकती है जैसे कि नेटनेवर या न्यूजफेयर या न्यूजगेटर जैसे प्लगइन्स का उपयोग करके (उन्हें आज़माने के लिए) दाईं ओर फ़ीड आकृति पर क्लिक करें)।

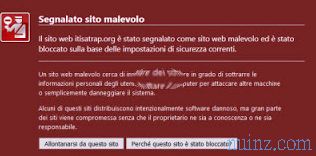

हालांकि, फ़ीड आंशिक और पूर्ण नहीं हो सकते हैं, और फिर यदि कोई साइट पतली हवा में गायब हो जाती है, तो आपको चोट लग सकती है।

टुकड़ा, इसलिए, हमें इसे तब भी डालना चाहिए जब आप एक समाचार साइट या इस तरह से एक ब्लॉग पढ़ना चाहते हैं।

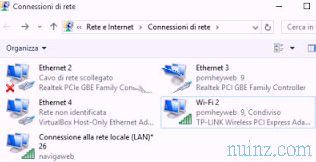

इसलिए लक्ष्य यह है कि किसी साइट को ऑफ़लाइन, शांत और बिना इंटरनेट कनेक्शन के, सीधे कंप्यूटर से पढ़ने के लिए वेब पेज ब्राउज़ करने के लिए सहेजा जाए ।

इंटरनेट एक्सप्लोरर, " फाइल -> सेव अस " जैसे ब्राउज़र बनाना, एक बहुत ही अव्यवहारिक समाधान है जो केवल तभी आवश्यक है जब आप किसी एकल पृष्ठ के फ्लाई पर प्रतिलिपि बनाना चाहते हैं और पूरी साइट का समूह नहीं।

किसी संपूर्ण साइट की प्रतिलिपि बनाने के लिए या, बेहतर, उन पृष्ठों की, जो आपको रुचि दे सकते हैं, ताकि वे आपके कंप्यूटर पर सहेजे जाएं और निर्देशिकाओं की संरचना के अनुसार व्यवस्थित हों और इसे नेविगेट करने योग्य बना सकें, आप ब्लैकचेयर ब्राउज़र प्रोग्राम का उपयोग कर सकते हैं जो उद्देश्य के लिए उपयुक्त है।

किसी संपूर्ण साइट की प्रतिलिपि बनाने के लिए या, बेहतर, उन पृष्ठों की, जो आपको रुचि दे सकते हैं, ताकि वे आपके कंप्यूटर पर सहेजे जाएं और निर्देशिकाओं की संरचना के अनुसार व्यवस्थित हों और इसे नेविगेट करने योग्य बना सकें, आप ब्लैकचेयर ब्राउज़र प्रोग्राम का उपयोग कर सकते हैं जो उद्देश्य के लिए उपयुक्त है।

एक बार ब्राउज़र स्थापित हो जाने के बाद, इंटरनेट से जुड़ा, आपको टाइप करना होगा, फ़ाइल में जाना होगा -> नया, सहेजे जाने वाले साइट का URL, यह भी तय करना:

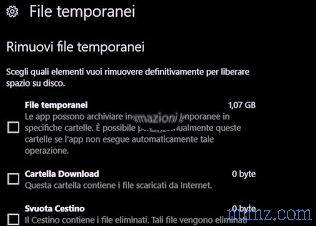

- जहां कंप्यूटर पर इसे बचाने के लिए;

- क्या केवल उन पृष्ठों को कॉपी करना है जो साइट की मेजबानी करने वाले सर्वर से आते हैं या उसी द्वारा लिंक की गई साइटों को बचाने के लिए;

- जाँच करने और सहेजने के लिए लिंक की गहराई, यानी यदि आप 3 सेट करते हैं, तो आप पहले से जुड़े पृष्ठों को, इससे जुड़े लोगों को और तीसरे स्तर के लिंक को बचाते हैं;

- यदि एक निश्चित डेटा आकार से बड़े पृष्ठों को नहीं बचा है, उदाहरण के लिए, यदि 200 से अधिक Kbytes;

- साइट संरचना के बाद के पृष्ठों को कॉपी करना है या पीसी पर उन सभी को कॉपी करना है या नहीं।

सभी सेटिंग्स को डिफ़ॉल्ट रूप से छोड़ते हुए, पृष्ठ को पूर्ण रूप से कॉपी किया जाता है और उसी तरह जैसे आप इसे ऑनलाइन देखते हैं और इसे देखने के लिए, बस उनमें से एक पर क्लिक करें, उदाहरण के लिए होम पेज पर, और फिर इसे सामान्य रूप से नेविगेट करें।

जानकारी की पूर्णता के लिए, मैं केवल इस बात का उल्लेख करता हूं कि एक वेबसाइट कई संरचित फाइलों से मिलकर बनी होती है, जैसे कि फोल्डर के साथ निर्देशिका, थोड़ा सा विंडोज की तरह।

यह संरचना इंटरनेट पते को देखने और बीच में / को नोटिस करने से दिखाई देती है।

उदाहरण के लिए www.sito.net होम पेज है, जैसे कि यह C: / Windows पर था, www.sito.net/2009/pippo.html एक ऐसा पेज है जो 2009 फोल्डर के अंदर है।

आधुनिक वेबसाइटों में समझने योग्य नामों के साथ एक निर्देशिका संरचना होती है जो आम तौर पर लिखित सामग्री को संदर्भित करती है, पुराने और गैर-अनुकूलित साइटों के बजाय संख्या और अक्षरों के साथ असंगत नाम होते हैं जो यादृच्छिक लगते हैं।

लेकिन इस पोस्ट में हमें इस तथ्य में बहुत दिलचस्पी नहीं है और हम जो इन तकनीकी बारीकियों के बारे में कुछ भी नहीं समझते हैं, हम सिर्फ एक वेबसाइट को बचाना चाहते हैं, न कि इसके कोड या संरचना की नकल करना, लेकिन इसे परामर्श करना और ऑफ़लाइन ब्राउज़ करना।

यदि आप एक प्रोग्रामर के रूप में कुछ और चाहते हैं, तो मैं HttTrack की रिपोर्ट कर सकता हूं जो खुद को "ऑफ़लाइन ब्राउज़र" या "वेबसाइट कापियर" के रूप में वर्णित करता है।

कार्यक्रम को स्थापित किया जाना है और एक बार खोला है, बस उस साइट का यूआरएल लिखें जिसे आप कॉपी करना चाहते हैं और इसे html कोड, फ़ाइलों और इसके पीछे की छवियों के साथ पूर्ण रूप से लिया जाएगा ।

READ ALSO: पीसी, टैबलेट और मोबाइल फोन पर कनेक्शन के बिना ऑफ़लाइन वेबसाइट खोलें और पढ़ें ।

मुझे नहीं लगता कि यह अक्सर होगा, अन्य बातों के अलावा इस लेख की उपयोगिता फीड की उपस्थिति से सीमित हो सकती है जो कि फीडडोमन या माइक्रोसॉफ्ट आउटलुक जैसे प्रोग्राम का उपयोग करके पीसी पर सेव की जा सकती है जैसे कि नेटनेवर या न्यूजफेयर या न्यूजगेटर जैसे प्लगइन्स का उपयोग करके (उन्हें आज़माने के लिए) दाईं ओर फ़ीड आकृति पर क्लिक करें)।

हालांकि, फ़ीड आंशिक और पूर्ण नहीं हो सकते हैं, और फिर यदि कोई साइट पतली हवा में गायब हो जाती है, तो आपको चोट लग सकती है।

टुकड़ा, इसलिए, हमें इसे तब भी डालना चाहिए जब आप एक समाचार साइट या इस तरह से एक ब्लॉग पढ़ना चाहते हैं।

इसलिए लक्ष्य यह है कि किसी साइट को ऑफ़लाइन, शांत और बिना इंटरनेट कनेक्शन के, सीधे कंप्यूटर से पढ़ने के लिए वेब पेज ब्राउज़ करने के लिए सहेजा जाए ।

इंटरनेट एक्सप्लोरर, " फाइल -> सेव अस " जैसे ब्राउज़र बनाना, एक बहुत ही अव्यवहारिक समाधान है जो केवल तभी आवश्यक है जब आप किसी एकल पृष्ठ के फ्लाई पर प्रतिलिपि बनाना चाहते हैं और पूरी साइट का समूह नहीं।

किसी संपूर्ण साइट की प्रतिलिपि बनाने के लिए या, बेहतर, उन पृष्ठों की, जो आपको रुचि दे सकते हैं, ताकि वे आपके कंप्यूटर पर सहेजे जाएं और निर्देशिकाओं की संरचना के अनुसार व्यवस्थित हों और इसे नेविगेट करने योग्य बना सकें, आप ब्लैकचेयर ब्राउज़र प्रोग्राम का उपयोग कर सकते हैं जो उद्देश्य के लिए उपयुक्त है।

किसी संपूर्ण साइट की प्रतिलिपि बनाने के लिए या, बेहतर, उन पृष्ठों की, जो आपको रुचि दे सकते हैं, ताकि वे आपके कंप्यूटर पर सहेजे जाएं और निर्देशिकाओं की संरचना के अनुसार व्यवस्थित हों और इसे नेविगेट करने योग्य बना सकें, आप ब्लैकचेयर ब्राउज़र प्रोग्राम का उपयोग कर सकते हैं जो उद्देश्य के लिए उपयुक्त है। एक बार ब्राउज़र स्थापित हो जाने के बाद, इंटरनेट से जुड़ा, आपको टाइप करना होगा, फ़ाइल में जाना होगा -> नया, सहेजे जाने वाले साइट का URL, यह भी तय करना:

- जहां कंप्यूटर पर इसे बचाने के लिए;

- क्या केवल उन पृष्ठों को कॉपी करना है जो साइट की मेजबानी करने वाले सर्वर से आते हैं या उसी द्वारा लिंक की गई साइटों को बचाने के लिए;

- जाँच करने और सहेजने के लिए लिंक की गहराई, यानी यदि आप 3 सेट करते हैं, तो आप पहले से जुड़े पृष्ठों को, इससे जुड़े लोगों को और तीसरे स्तर के लिंक को बचाते हैं;

- यदि एक निश्चित डेटा आकार से बड़े पृष्ठों को नहीं बचा है, उदाहरण के लिए, यदि 200 से अधिक Kbytes;

- साइट संरचना के बाद के पृष्ठों को कॉपी करना है या पीसी पर उन सभी को कॉपी करना है या नहीं।

सभी सेटिंग्स को डिफ़ॉल्ट रूप से छोड़ते हुए, पृष्ठ को पूर्ण रूप से कॉपी किया जाता है और उसी तरह जैसे आप इसे ऑनलाइन देखते हैं और इसे देखने के लिए, बस उनमें से एक पर क्लिक करें, उदाहरण के लिए होम पेज पर, और फिर इसे सामान्य रूप से नेविगेट करें।

जानकारी की पूर्णता के लिए, मैं केवल इस बात का उल्लेख करता हूं कि एक वेबसाइट कई संरचित फाइलों से मिलकर बनी होती है, जैसे कि फोल्डर के साथ निर्देशिका, थोड़ा सा विंडोज की तरह।

यह संरचना इंटरनेट पते को देखने और बीच में / को नोटिस करने से दिखाई देती है।

उदाहरण के लिए www.sito.net होम पेज है, जैसे कि यह C: / Windows पर था, www.sito.net/2009/pippo.html एक ऐसा पेज है जो 2009 फोल्डर के अंदर है।

आधुनिक वेबसाइटों में समझने योग्य नामों के साथ एक निर्देशिका संरचना होती है जो आम तौर पर लिखित सामग्री को संदर्भित करती है, पुराने और गैर-अनुकूलित साइटों के बजाय संख्या और अक्षरों के साथ असंगत नाम होते हैं जो यादृच्छिक लगते हैं।

लेकिन इस पोस्ट में हमें इस तथ्य में बहुत दिलचस्पी नहीं है और हम जो इन तकनीकी बारीकियों के बारे में कुछ भी नहीं समझते हैं, हम सिर्फ एक वेबसाइट को बचाना चाहते हैं, न कि इसके कोड या संरचना की नकल करना, लेकिन इसे परामर्श करना और ऑफ़लाइन ब्राउज़ करना।

यदि आप एक प्रोग्रामर के रूप में कुछ और चाहते हैं, तो मैं HttTrack की रिपोर्ट कर सकता हूं जो खुद को "ऑफ़लाइन ब्राउज़र" या "वेबसाइट कापियर" के रूप में वर्णित करता है।

कार्यक्रम को स्थापित किया जाना है और एक बार खोला है, बस उस साइट का यूआरएल लिखें जिसे आप कॉपी करना चाहते हैं और इसे html कोड, फ़ाइलों और इसके पीछे की छवियों के साथ पूर्ण रूप से लिया जाएगा ।

READ ALSO: पीसी, टैबलेट और मोबाइल फोन पर कनेक्शन के बिना ऑफ़लाइन वेबसाइट खोलें और पढ़ें ।